Google 6 日發表新一代人工智慧(AI)模型「Gemini」,能夠語音並且即時得與人工智慧的互動震驚了整個產業。然而,事實卻並非如同影片呈現,實際上影片的背後既不是實時進行的,也不是用語音進行的…

(前情提要:Google新AI模型Gemini為何強大?iKala創辦人:ChatGPT難以對抗谷歌的生態版圖)

(背景補充:輾壓GPT-4!Google出殺手鐧「Gemini原生多模態模型」: AI 理解力首超人類、離線可用、搭載Pixel 8 Pro)

科技巨頭 Google 6 日發表新一代人工智慧(AI)模型「Gemini」,官方稱在 32 項 AI 測試中有 30 項的評分超越了 OpenAI 的 GPT-4。官方秀出的展示影片中,與多模型人工智慧的互動令社群媒體瞠目結舌,更被認為是「輾壓 GPT-4」的殺手級產品。沒有想到的是,這場競賽很快地迎來反轉,Gemini 似乎跌落了神壇…

官方展示影片全靠剪輯?

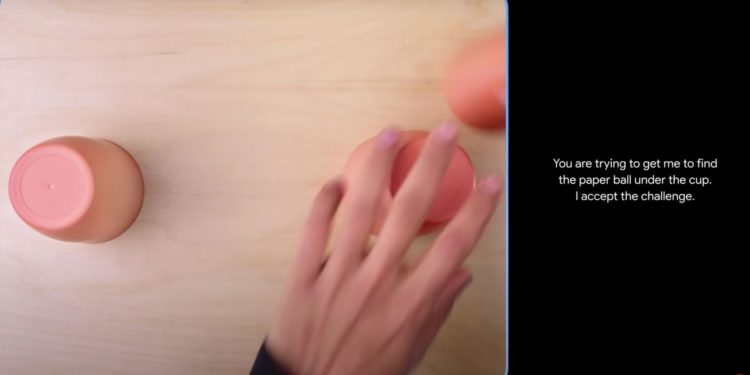

回顧官方的影片,首次展示的成果,已經展示了 Google DeepMind AI 實驗室多年來在推理能力上的進步。這款新型智能模型能夠預測一個紙球從塑料杯底部移動,或者在點連點圖形成螃蟹之前,立即識別出它將成為螃蟹的形狀,這種能力在其他人工智慧模型中是罕見的。

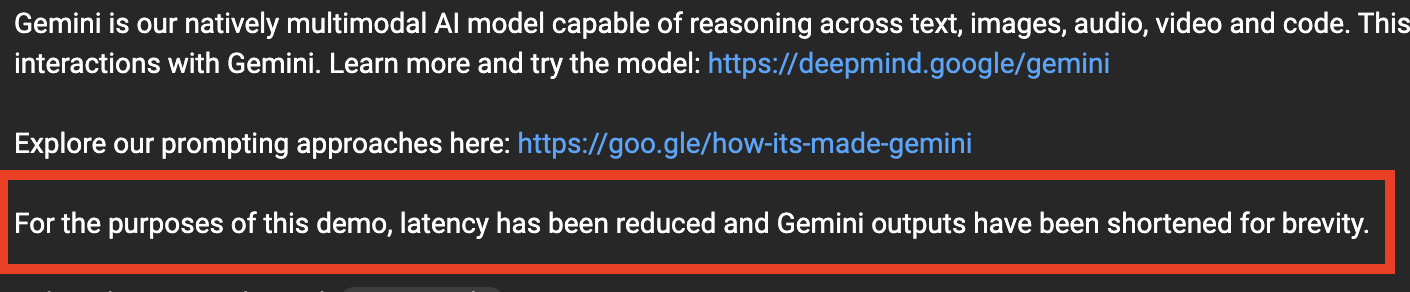

然而,在影片發布後不久,大家卻發現,Google 過幾天後,在底下加了一段備註表示:

「為了這次的演示,我們降低了反應延遲時間,並且簡化了 Gemini 輸出的內容長度,以便於簡潔地展示。」

這句話意味著每個與人工智慧的對談過程中,所花費的時間實際上比影片中的時間要長,具體要等待 Gemini 的回應時間是多久,Google 並沒有公佈。

發言人:語音互動完全不存在?

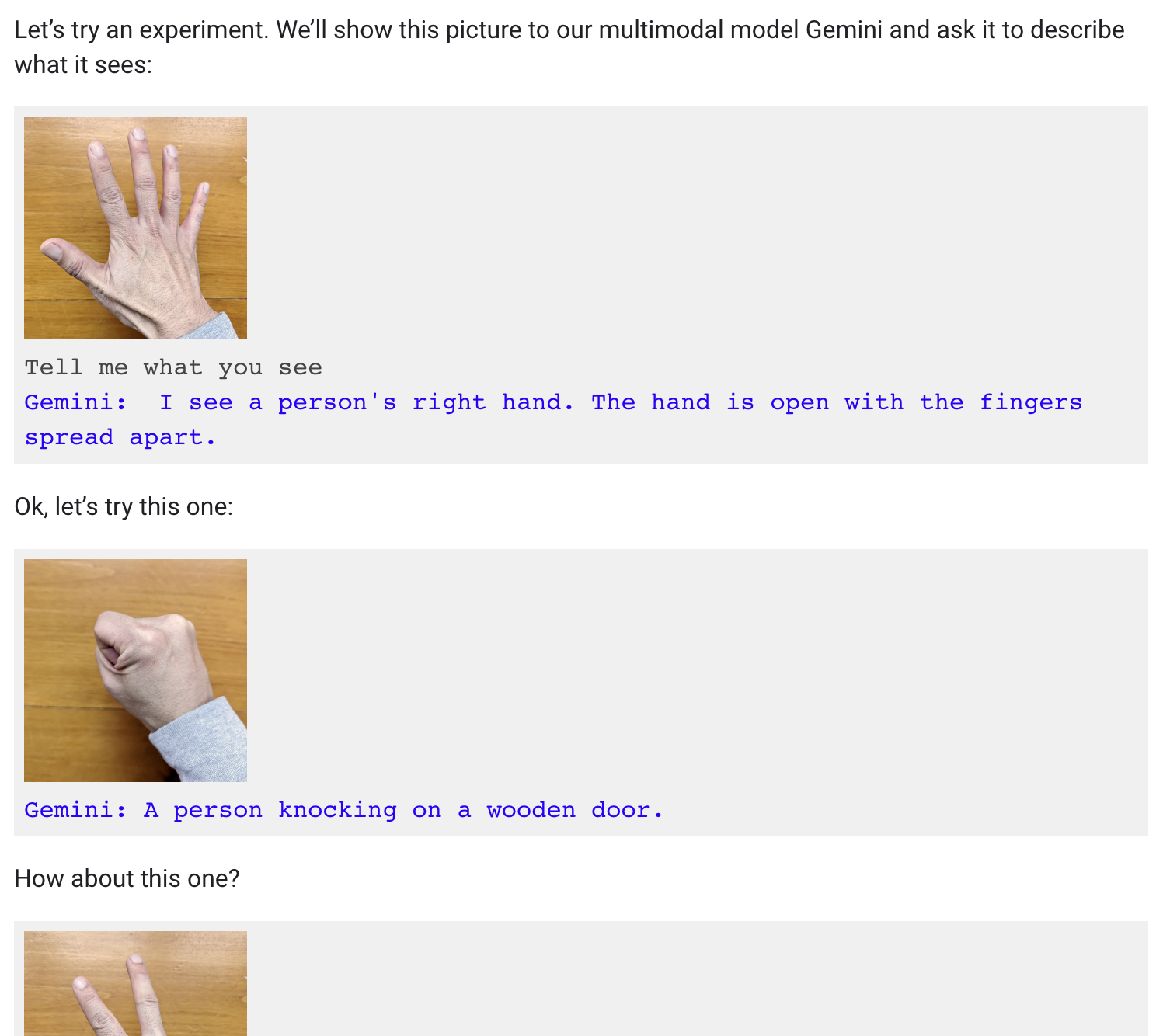

據彭博社的報導,實際上這部影片的演示既不是實時進行的,也不是用語音進行的。Google 的一位發言人對彭博社說明,該影片是利用靜態照片和文字提示製作而成。此外,他們還揭露開發者是如何使用手部照片、繪畫作品或其他物體來與 Gemini 進行互動。

換句話說,演示中的聲音其實是在朗讀人類製作給 Gemini 的提示,並向它展示靜態圖像。這與整部影片呈現的效果截然不同。目前社群媒體上的許多理解,皆是以為人們可以與 Gemini 進行流暢的語音對話,同時它能即時觀察並回應周圍環境,然而事實並非如此。

Google:是為了激勵開發者…

值得一提的是,在 AI 產品的展示會上,不管是 OpenAI、馬斯克 Grok,目前也都沒有實際操作的演練,大部分都是截圖或錄影,因為 AI 輸出的結果是不一定的,相同的參數與提示詞,跑出來的結果可能都大不相同。對此, Gemini 共同負責人 Oriol Vinyals 也發布推文認為展示過程中並沒有不正當的行為:

影片中所有的用戶提示和輸出都是真實的,只是為了簡潔而縮短。這部影片展示了使用 Gemini 建立的多模式用戶體驗可能會是什麼樣子。我們製作這部影片是為了激發開發者的靈感。

很快地,從 12 月 13 日起,開發者和企業客戶將能夠通過 Google AI Studio 或 Google Cloud Vertex AI 中的 Gemini API 存取 Gemini Pro。此外,Android 開發人員也將能夠使用 Gemini Nano 進行應用程式的開發和建置,到時候「Gemini」是否能夠成為超越 GPT-4 的殺手級產品,正受全世界關注。

📍相關報導📍

Google Cloud加入以太坊再質押協議「EigenLayer」測試網、參與 Goerli 節點營運