美國 AI 晶片新創公司 Groq 在近期爆紅,Groq 最近開發出語言處理單元(LPU)晶片,其大型語言模型(LLM)的推理效能比以輝達 GPU 驅動的微軟 Azure 雲端服務快上 18 倍,可能成為輝達 GPU 的競爭對手。

(前情提要:V神:該為L1添加複雜功能,減輕L2負擔!我期待AI幫忙抓Bug)

(背景補充:羨慕NVIDIA股票賺到飛天?關注潛力加密AI代幣專案)

AI 晶片公司 Groq 最近在社交媒體上掀起廣泛關注,Groq 宣稱創下「世上最快的大型語言模型速度」,在社交媒體瘋傳的演示影片中,其聊天機器人展現出驚人的回應速度,幾乎是立即生成,使當前版本的 ChatGPT、 Gemini 、 Grok… 等一系列 AI 聊天機器人看起來都很遲鈍。

The first public demo using Groq: a lightning-fast AI Answers Engine.

It writes factual, cited answers with hundreds of words in less than a second.

More than 3/4 of the time is spent searching, not generating!

The LLM runs in a fraction of a second.https://t.co/dVUPyh3XGV https://t.co/mNV78XkoVB pic.twitter.com/QaDXixgSzp

— Matt Shumer (@mattshumer_) February 19, 2024

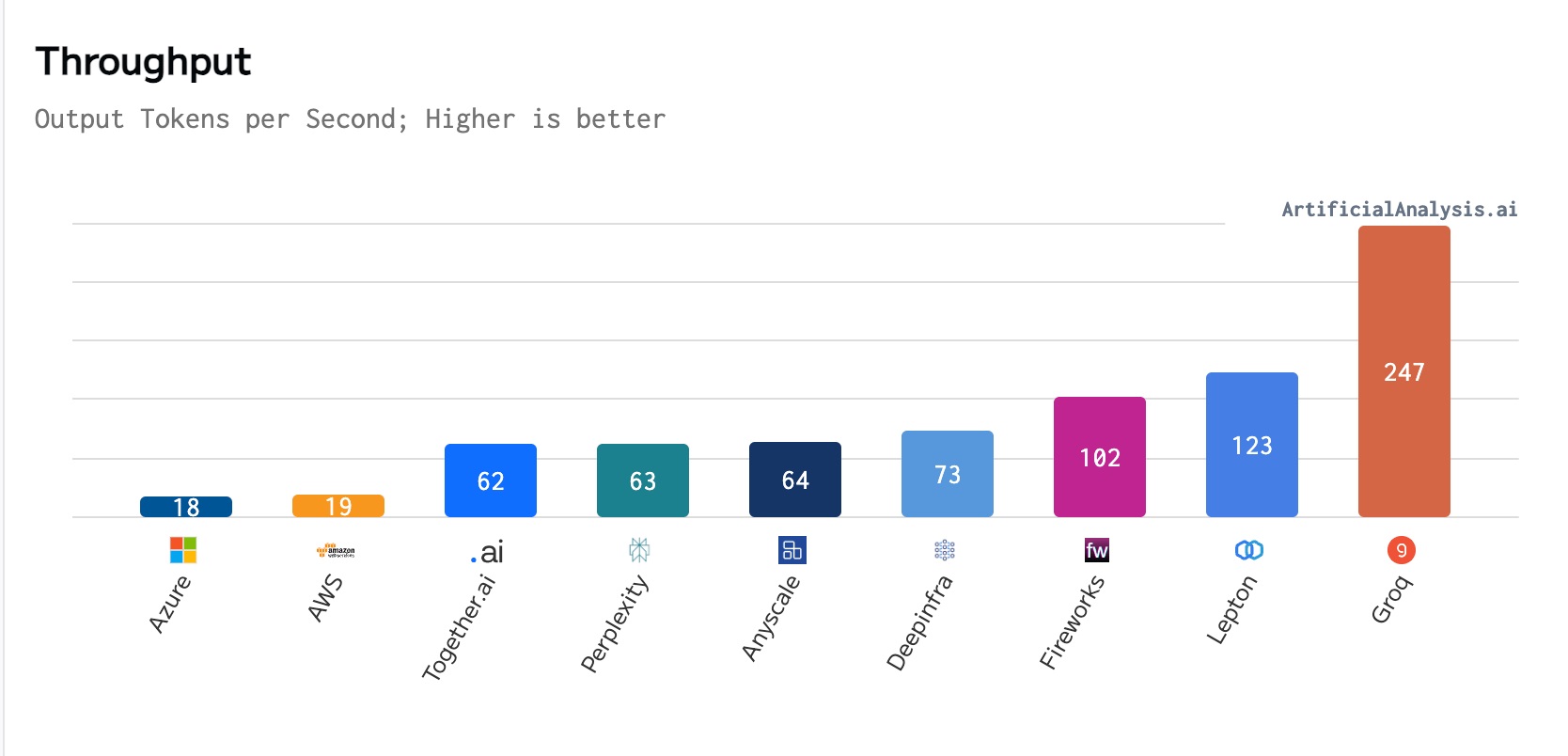

在 ArtificialAnalysis.ai 最近進行的基準測試中,Groq 在吞吐量、總反應時間等幾個關鍵性能指標都遠勝其他 8 個競爭對手,Groq 可每秒產生約 247 個 token,相較之下,微軟 Azure 每秒產生約 18 個 token,故倘若 ChatGPT 在 Groq 上運行,生成速度將能大增 13 倍。

Cryptopolitan 報導,Groq 能實現如此成績,是因為其開發新 AI 晶片「語言處理單元」(LPU),透過自研晶片來運行其他開源模型的 AI 語言介面,LPU 被用來解決 CPU 和 GPU 等舊技術的限制。

在面對大型語言模型(LLM)的龐大運算需求時,傳統處理架構往往無法滿足需求,但 Groq 使用新的張量流處理器(TPS)架構架構來實現 LLM 運算, TPS 和 LPU 憑藉其快速推理、降低功耗的優勢,可望改變處理數據的方式。

LPU 專用於確定性 AI 運算,其擺脫 GPU 的傳統單指令多數據(SIMT)模型,這種轉變可提升性能、減少能源消耗。它使 LPU 成為未來更環保的選擇,

資深風險架構師 k_zer0s 發推表示,Groq 的 LPU 速度比 GPU 快約 20 倍,由於推理運行使用的數據比模型訓練要少得多,因此, LPU 更節能,與用於推理任務的輝達 GPU 相比,LPU 從外部記憶體讀取的數據更少,功耗也更少。

Groq's LPU is faster than Nvidia GPUs, handling requests and responding more quickly.

Groq's LPUs don't need speedy data delivery like Nvidia GPUs do because they don't have HBM in their system. They use SRAM, which is about 20 times faster than what GPUs use. Since inference… pic.twitter.com/mLKn81KzhP

— k_zer0s (@k_zer0s) February 19, 2024

開放免費試用

目前 Groq 開發免費試用,官網提供 3 種不同 LLM 模型的 AI 聊天機器人,包括 Meta 旗下 Llama 2、 Mistal AI 旗下的 Mixtral-8x7B 和 Mistral 7B,用戶可免費體驗在 LPU 助力下,有著迅速回應速度的聊天機器人。

📍相關報導📍

輝達財報出爐:營收年增265%超預期,Nvidia 盤後大漲9%!AI 概念幣齊揚(TAO、RNDR、AGIX..)