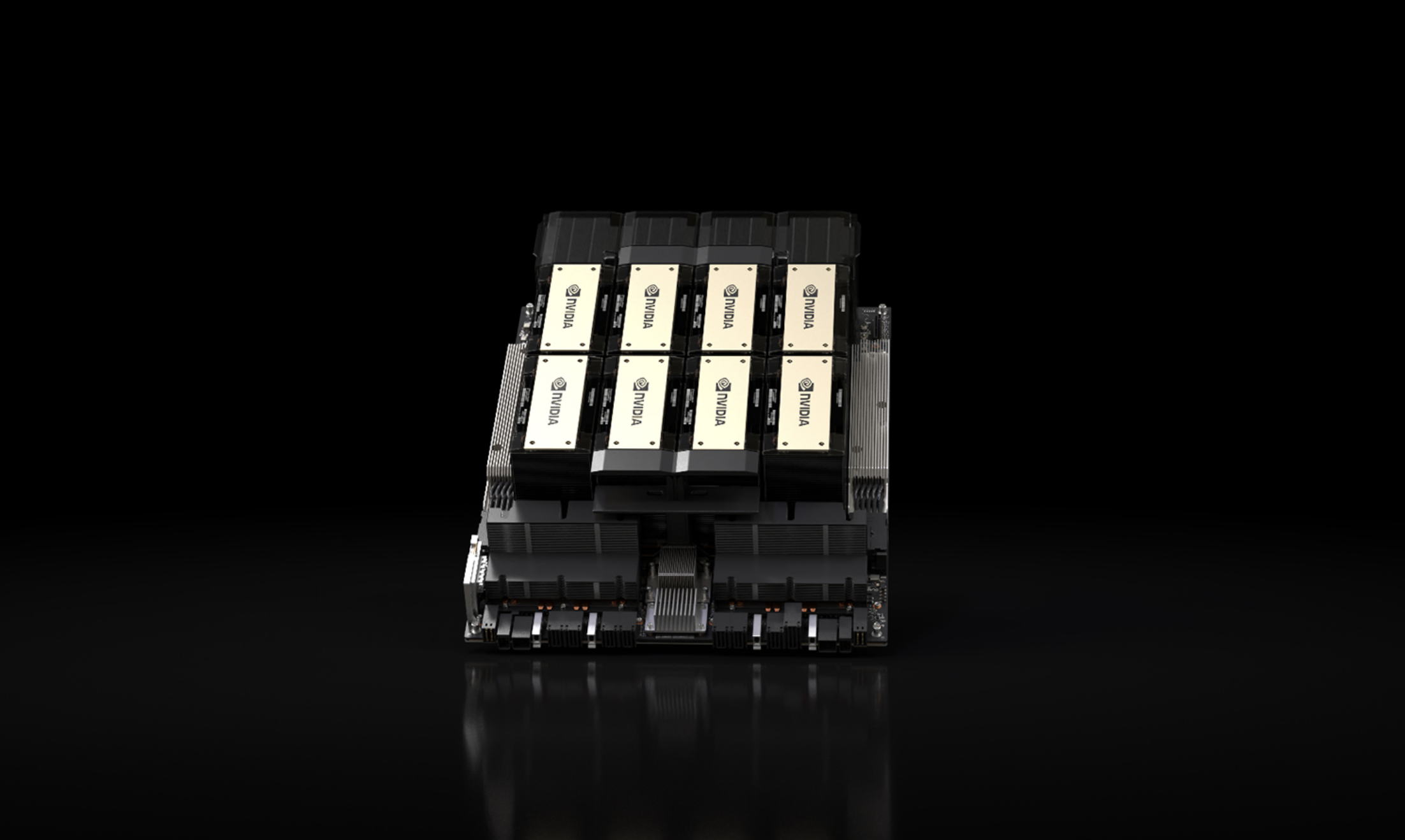

輝達(Nvidia)13 日宣布推出最新 AI 晶片 NVIDIA HGX H200,相比其前身 NVIDIA A100,其內存容量和頻寬分別提高了近 1 倍和 2.4 倍。預計在 2024 年第二季度,開始向全球系統製造商和雲端服務供應商供貨。

(前情提要:急殺》比特幣清晨重挫34800、以太坊失守2000,10月CPI降溫反帶崩市場?)

(背景補充:美國再擴大晶片禁令,增列40多國!Nvidia盤中重挫8%,官宣對財報影響不大)

美國勞工統計局(BLS)昨(14)日晚間發佈 10 月 CPI(消費者物價指數)報告,年增率 3.2% 低於預期、核心 CPI 4% 也創 2021 年 9 月以來的新低。降溫的通膨數據推動了美國科技股大幅上漲,其中輝達(Nvidia)股價更是創下歷史新高。

輝達本週宣布推出 H200

除了預期聯準會本輪升息循環很可能已經結束之外,輝達在本週 13 日也發布新聞稿,正式推出最新 AI 晶片「 NVIDIA HGX H200」。

據了解,H200 配備了 NVIDIA H200 Tensor Core GPU 和先進的內存技術,能夠處理大量數據,滿足生成式 AI 和高性能計算(HPC)工作負載的更龐大需求。

NVIDIA 表示 H200 是首款提供 HBM3e 內存的 GPU,相比其前身 NVIDIA A100,其內存容量和頻寬分別提高了近 1 倍和 2.4 倍,達到 141 GB 內存和每秒 4.8TB 的傳輸速度,幫助進行「推論」任務,這意味著它可以使用已經訓練好的大型語言模型來創造文字、圖片或進行預測。

輝達通過測試表明,當使用 Meta 的開源AI模型「Llama 2」時,他們新推出的 H200 在推論任務上的速度幾乎是前代 H100 的兩倍,更值得一提的是 H200 與 H100 是兼容的,也意味著目前使用 H100 來訓練 AI 模型的企業,可以毫無障礙地升級到 H200,無需更改他們現有的伺服器系統或軟體規格。

2024 年 Q2 開始供貨

預計在 2024 年的第二季度,輝達將開始向全球系統製造商和雲端服務供應商供貨 H200,這款處理器的主要競爭對手是超微(AMD)的MI300X GPU,MI300X 也增加了額外的記憶體,同樣可協助大型 AI 的模型執行推論功能。

輝達進一步宣布,包括亞馬遜 AWS、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 在內的雲端服務提供商將成為首批部署 H200 的公司。此外, CoreWeave、Lambda 和 Vultr 等公司也計劃加入這一行列。

📍相關報導📍

AI大未來!這6個加密專案加入了 NVIDIA Inception 計劃